撰文:Vitalik Buterin

编译:Luffy,Foresight News

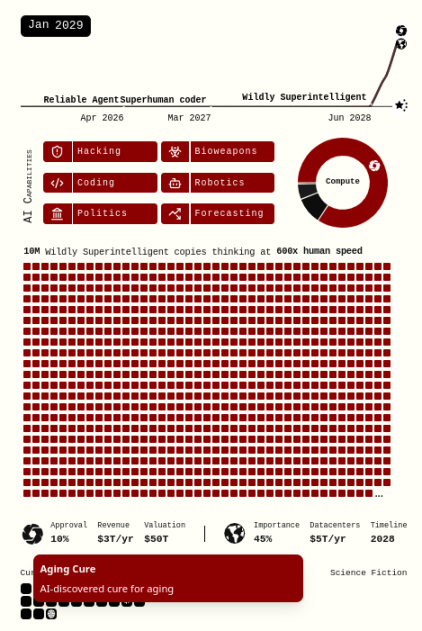

今年 4 月,Daniel Kokotajlo、Scott Alexander 等人发布了一份报告《AI 2027》,描绘了 「我们对未来 5 年超人类 AI 影响的最佳猜测」。他们预测,到 2027 年,超人类 AI 将诞生,而整个人类文明的未来将取决于类 AI 的发展结果:到 2030 年,我们要么迎来乌托邦(从美国视角看),要么走向彻底毁灭(从全人类视角看)。

此后几个月,针对这一场景的可能性,出现了大量观点各异的回应。在批判性回应中,多数聚焦于 「时间线过快」 的问题:AI 的发展真的会如 Kokotajlo 等人所说的那样持续加速,甚至愈演愈烈吗?这场辩论在 AI 领域已持续数年,许多人对超人类 AI 会如此迅速地到来深表怀疑。近年来,AI 能够自主完成的任务时长大约每 7 个月翻一番。若这一趋势延续下去,AI 要能自主完成相当于整个人类职业生涯的任务,得等到 2030 年代中期。这一进展虽然也很快,但远晚于 2027 年。

那些持有更长时间线观点的人倾向于认为,「插值 / 模式匹配」(当前大语言模型所做的工作)与 「外推 / 真正的原创思维」(目前仍只有人类能做到)存在本质区别。要实现后者的自动化,可能需要我们尚未掌握甚至无从入手的技术。或许,我们只是在重蹈计算器大规模应用时的覆辙:错误地认为,既然我们已快速实现某类重要认知的自动化,其他一切也将很快跟进。

这篇文章不会直接介入时间线之争,也不会涉及 「超级 AI 是否默认具有危险性」 这一(非常重要的)争论。但需说明的是,我个人认为时间线会比 2027 年更长,而且时间线越长,我在这篇文章中提出的论点就越有说服力。总体而言,本文将从另一个角度提出批判:

《AI 2027》场景隐含一个假设:领先 AI(「Agent-5」 及后续的 「Consensus-1」)的能力会迅速提升,直至拥有神一般的经济与破坏力量,而其他所有人的(经济与防御)能力则基本停滞不前。这与情景本身 「即便是在悲观世界里,到 2029 年我们也有望治愈癌症、延缓衰老,甚至实现意识上传」 的说法自相矛盾。

我将在本文中描述的一些对策,读者或许会觉得技术上可行,但在短时间内部署到现实世界却不切实际。多数情况下,我同意这一点。然而,《AI 2027》场景并非基于当下的现实世界,而是假设在 4 年内(或任何可能带来毁灭的时间线内),技术将发展到让人类拥有远超当前的能力。因此,我们来探讨一下:若不仅一方拥有 AI 超能力,而是双方都拥有,会发生什么?

生物末日远非场景描述的那么简单